한국전자통신연구원(ETRI)은 인공지능(AI) 시스템의 위험을 미리 찾아내는 'AI 레드팀 테스팅' 표준과 소비자가 AI의 신뢰 수준을 쉽게 이해할 수 있는 '신뢰성 사실 라벨(TFL)' 표준을 국제표준화기구(ISO/IEC)에 제안했다고 19일 밝혔다.

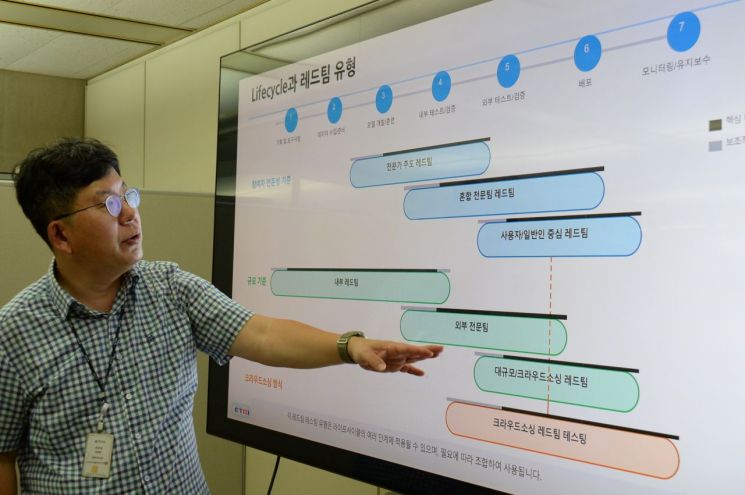

ETRI가 국제표준화기구에 제안한 'AI 레드팀 테스팅'은 AI 시스템의 안전성을 공격적으로 탐색해 테스트하는 방법이다. 생성형 AI가 잘못된 정보를 내놓거나 사용자 보호 장치를 피해 악용되는 상황을 미리 찾아내는 것이 일종의 예다.

ETRI는 이 분야 국제표준인 국제표준화기구 '42119-7'의 에디터 역할을 맡아 의료·금융·국방 등 분야에 적용할 수 있는 국제 공통시험 절차와 방법을 개발하고 있다.

또 서울아산병원과 협력해 의료 전용 레드팀 평가 방법론을 개발, 첨단 AI 기술을 적용한 디지털의료제품의 레드팀 시험 체계를 만들어 실증 테스팅을 진행하는 중이다. 이외에도 STA·네이버·업스테이지·셀렉트스타·KT·LG AI 연구원 등 주요 기업과 협의체를 구성해 AI 레드팀 국제표준화 협력을 강화하고 있다.

현재 ETRI는 신뢰성 사실 라벨로 국제표준화기구의 '42117 시리즈' 표준 개발도 주도하고 있다. 이 표준은 기업이 스스로 정보를 제공하거나, 제3의 기관이 검증·인증하는 다양한 방식으로 운영될 수 있다.

AI 시스템이 얼마나 신뢰할 수 있는지를 한눈에 알 수 있도록 시각화해 식품의 영양성분표처럼 소비자에게 투명한 정보를 제공하는 게 핵심 기능이다. 향후에는 AI의 탄소배출량(탄소발자국) 등 ESG 요소를 함께 반영하는 방안도 검토되고 있다.

이 표준은 인공지능 활용 조직의 국제 인증 표준으로 사용되는 'AI 경영시스템 표준(ISO/IEC 42001)'과도 연계돼 개발한 제품 및 서비스가 얼마나 신뢰할 수 있는지를 입증하는 틀로 활용될 수 있다.

'AI 레드팀 테스팅' 표준과 '신뢰성 사실 라벨' 표준은 정부가 추진하는 '소버린 AI(주권형 AI)', 'AI G3 도약' 전략과도 맞닿아 있다. 단순한 기술력 확보를 넘어 글로벌 AI 규칙을 만드는 주도권 경쟁에 실질적인 기여를 할 수 있다는 의미다.

지금 뜨는 뉴스

이승윤 ETRI 표준연구본부장은 "AI 레드팀 테스팅과 신뢰성 라벨은 미국, 유럽(EU) 등 각국의 AI 규제정책에 포함된 핵심 기술 요소"라며 "향후 정립될 AI 레드팀 테스팅과 신뢰성 라벨의 국제 표준은 전 세계 AI 시스템의 안전과 신뢰성을 평가하는 데 공통기준으로 활용될 것"이라고 말했다.

대전=정일웅 기자 jiw3061@asiae.co.kr

<ⓒ투자가를 위한 경제콘텐츠 플랫폼, 아시아경제(www.asiae.co.kr) 무단전재 배포금지>

![전문가 4인이 말하는 '의료 생태계의 대전환'[비대면진료의 미래⑥]](https://cwcontent.asiae.co.kr/asiaresize/319/2026013014211022823_1769750471.png)

![[뉴욕증시]美-이란 전운에 3대 지수 일제히 하락 출발](https://cwcontent.asiae.co.kr/asiaresize/308/2025112108183126325_1763680712.png)