AI 오류·왜곡 리스크 최우선 우려

책임 기준 핵심은 최종 승인자

시스템보다 조직 책임 인식 확산

윤리 기준도 기술보다 통제에 방점

AI는 도구 판단은 사람

인공지능(AI) 도입이 확산되면서 기업들이 가장 크게 우려하는 위험 요인으로는 기술 경쟁력보다 'AI 오류'와 그에 따른 책임 문제가 꼽힌 것으로 나타났다. 업무 효율과 생산성 향상에도 불구하고, AI가 만들어낸 결과의 오류나 왜곡이 조직과 기업에 미칠 영향을 가장 경계하고 있다는 의미다.

아시아경제가 지난달 8일부터 19일까지 국내 주요 100대 기업의 인사·전략·조직·기획 부서 담당자를 대상으로 실시한 'AI 도입 이후 조직 변화 실태조사' 결과, AI 사용에서 가장 중요하게 생각하는 윤리 기준으로 'AI 결과의 오류·왜곡 방지 기준'을 선택한 기업이 74곳 중 26곳으로 35.1%를 기록해 가장 많았다.

이어 'AI 사용 시 책임 주체 기준'을 꼽은 기업이 21곳으로 28.4%, 'AI 사용 과정의 기록·추적 기준'을 중시한다고 답한 기업이 15곳으로 20.3%를 차지했다. '고객 보호 기준'을 최우선으로 본다는 응답은 12곳으로 16.2%에 그쳤다. AI가 고객 접점이나 의사결정 과정에 활용되는 상황에서, 기업들이 가장 우려하는 지점은 기술 활용 그 자체보다 오류 발생 가능성과 그 파장을 통제하는 문제임을 보여주는 결과다.

AI 오류에 대한 경계는 책임 판단 방식에서도 뚜렷하게 드러났다. AI로 인한 업무 리스크가 발생했을 때 책임 주체를 묻는 질문에 대해, '해당 업무의 최종 승인자'를 책임 주체로 본다는 응답이 25곳으로 33.8%를 기록했다. '경영진이나 조직 차원의 책임'이라고 답한 기업도 19곳으로 25.7%에 달했다.

반면 'AI 시스템 운영·관리 부서'를 책임 주체로 본다는 응답은 16곳으로 21.6%, '해당 업무의 실무 담당자'를 꼽은 응답은 14곳으로 18.9%에 그쳤다. AI가 업무를 수행하더라도, 결과에 대한 책임은 시스템이나 개인이 아니라 최종 판단권자와 조직이 져야 한다는 인식이 우세한 셈이다.

이 같은 응답은 기업들이 AI를 독립적인 의사결정 주체로 받아들이기보다, 사람의 판단을 보조하는 도구로 활용하고 있음을 보여준다. AI가 제시한 결과를 그대로 따르기보다는, 사람이 이를 검토하고 승인하는 구조를 유지하지 않으면 조직 전체가 감당해야 할 리스크가 커질 수 있다는 판단이 깔려 있다.

지금 뜨는 뉴스

조사에 참여한 기업들은 AI 도입이 본격화될수록 기술 성능보다 오류 관리와 책임 구조가 더 중요한 과제로 부상하고 있다고 보고 있다. AI 활용 범위가 넓어질수록 작은 오류 하나가 의사결정, 고객 신뢰, 법적 분쟁으로까지 이어질 수 있기 때문이다.

박소연 기자 muse@asiae.co.kr

<ⓒ투자가를 위한 경제콘텐츠 플랫폼, 아시아경제(www.asiae.co.kr) 무단전재 배포금지>

![[AI시대, 일자리가 바뀐다]기업들이 가장 두려워하는 건 ‘AI오류’](https://cphoto.asiae.co.kr/listimglink/1/2025082609020296224_1756166522.jpg)

![[AI시대, 일자리가 바뀐다]기업들이 가장 두려워하는 건 ‘AI오류’](https://cphoto.asiae.co.kr/listimglink/1/2026010318015077456_1767430910.jpg)

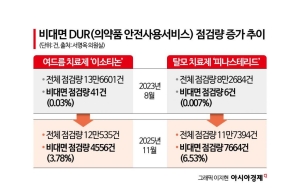

![전문가 4인이 말하는 '의료 생태계의 대전환'[비대면진료의 미래⑥]](https://cwcontent.asiae.co.kr/asiaresize/319/2026013014211022823_1769750471.png)