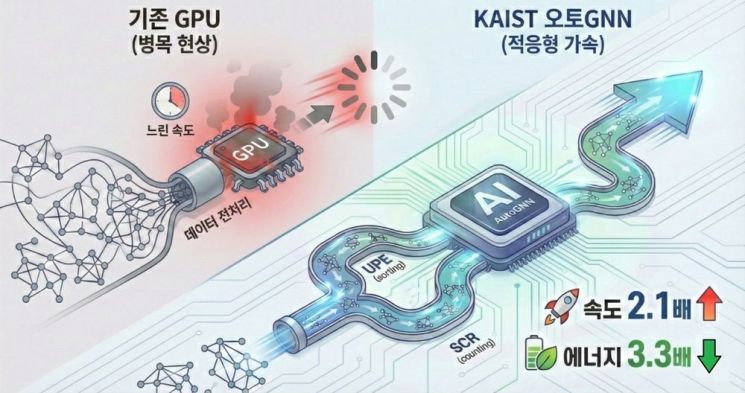

엔비디아보다 추론 속도가 2.1배 빠른 인공지능(AI) 반도체 기술이 국내에서 개발됐다. 이 기술의 핵심은 그래프 전처리(Graph Preprocessing) 과정의 병목 현상을 해결해 추론 속도를 향상한 데 있다.

KAIST는 전기 및 전자공학부 정명수 교수 연구팀이 그래프 신경망(Graph Neural Network·GNN) 기반의 AI 추론 속도를 획기적으로 높인 AI 반도체 기술 '오토GNN'을 개발했다고 5일 밝혔다.

그래프 신경망은 유튜브 영상을 추천하거나 금융사기 탐지처럼 사람 사이의 복잡한 관계를 빠르게 분석하는 핵심 AI 기술이다. 그래프는 그림이 아니라 사람과 사람 사이의 연결 관계를 뜻한다. 연구팀이 개발한 오토GNN은 엔비디아보다 지연을 줄여 추천 속도는 2.1배 빠르고 전력 소모까지 낮춘 게 강점으로 꼽힌다.

오토GNN 개발 과정에서 연구팀은 AI 추론 이전 단계인 그래프 전처리가 서비스 지연의 주된 원인으로 작용하는 것을 밝혀냈다. 그래프 전처리는 전체 계산 시간의 70~90%를 차지하지만 기존 GPU는 복잡한 관계 구조를 정리하는 연산에 한계를 보여 병목 현상이 발생한다는 것이다.

이를 해결하기 위해 연구팀은 입력 데이터 구조에 따라 반도체 내부 회로를 실시간 바꾸는 '적응형 AI 가속기' 기술을 설계했다. 분석할 데이터의 연결방식에 맞춰 반도체가 스스로 가장 효율적인 구조를 찾아 바꾸는 방식이다.

연구팀은 필요한 데이터만 골라내는 UPE 모듈과 이를 빠르게 정리·집계하는 SCR 모듈도 반도체 안에서 구현했다. 데이터의 양이나 형태가 바뀌면 이에 맞춰 최적의 모듈 구성이 자동으로 적용돼 어떤 상황에서도 안정적인 성능을 유지할 수 있도록 한 것이다.

이 결과 성능 평가에서 오토GNN은 엔비디아의 고성능 GPU(RTX 3090)보다 2.1배 빠른 처리 속도를 기록했다. 일반 CPU보다는 9배 빠른 성능이다. 여기에 더해 에너지 소모를 3.3배 줄이는 효율성까지 확보했다고 연구팀은 강조했다.

이번 기술은 추천 시스템이나 금융사기 탐지처럼 복잡한 관계 분석과 빠른 응답이 필요한 AI 서비스에 즉시 적용할 수 있다.

데이터 구조에 따라 스스로 최적화되는 AI 반도체 기술을 확보함으로써 향후 대규모 데이터를 다루는 지능형 서비스의 속도와 에너지 효율을 동시에 높이는 것이 가능할 것으로 평가받는다.

정 교수는 "이번 연구는 불규칙한 데이터 구조를 효과적으로 처리할 수 있는 유연한 하드웨어 시스템을 구현했다는 점에서 의미를 갖는다"며 "추천 시스템은 물론 금융·보안 등 실시간 분석이 필요한 다양한 AI 분야에서도 오토GNN을 활용할 수 있을 것으로 기대한다"고 말했다.

지금 뜨는 뉴스

한편 이번 연구는 최근 호주 시드니에서 열린 컴퓨터 아키텍처 분야 국제학술대회 'IEEE International Symposium on High-Performance Computer Architecture (HPCA 2026)'에서 발표됐다.

대전=정일웅 기자 jiw3061@asiae.co.kr

<ⓒ투자가를 위한 경제콘텐츠 플랫폼, 아시아경제(www.asiae.co.kr) 무단전재 배포금지>

![전문가 4인이 말하는 '의료 생태계의 대전환'[비대면진료의 미래⑥]](https://cwcontent.asiae.co.kr/asiaresize/319/2026013014211022823_1769750471.png)

![옆집 어르신도 주식창 본다며 난리… 1년 만에 순자산 3조 이상 ETF 2.3배 '쑥'[재테크 풍향계]](https://cwcontent.asiae.co.kr/asiaresize/308/2026020508063229180_1770246393.png)

![[굿모닝증시]美기술주 급락에도 반도체주 완충…약보합 출발 전망](https://cwcontent.asiae.co.kr/asiaresize/308/2026020415580428747_1770188284.jpg)

![[클릭 e종목]](https://cwcontent.asiae.co.kr/asiaresize/308/2026020507485129147_1770245330.jpg)